Lokaler Rechnungsanalyse-Workflow mit Ollama und strukturierter Ausgabe

Selbst gehosteter Workflow zur Extraktion strukturierter Rechnungsdaten mithilfe eines lokalen Ollama-Sprachmodells und schema-basierter Ausgabeverarbeitung.

Dieser Workflow implementiert eine vollständig lokale Pipeline zur Rechnungsanalyse, die strukturierte Daten aus Rechnungsdokumenten extrahiert, ohne auf cloudbasierte Modelle angewiesen zu sein. Der Fokus liegt auf Determinismus, Datenschutz und vorhersehbarer Ausgabe für nachgelagerte Automatisierungen.

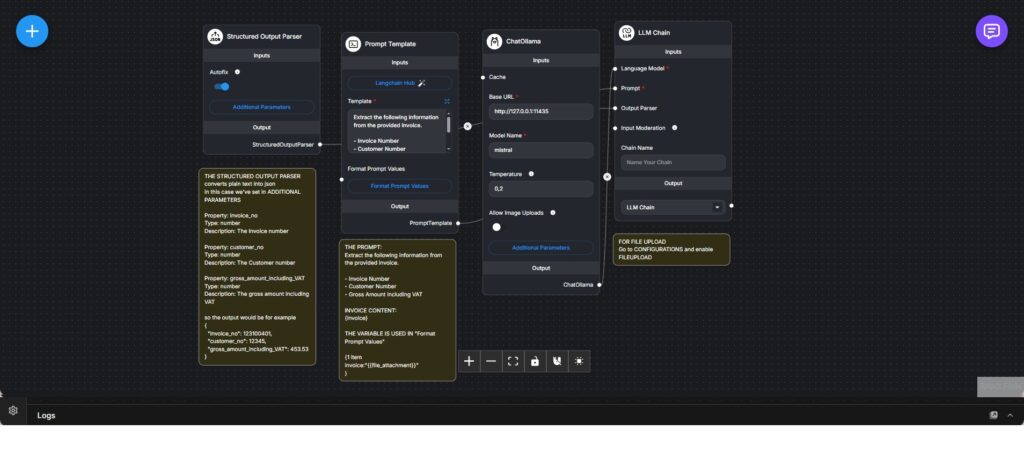

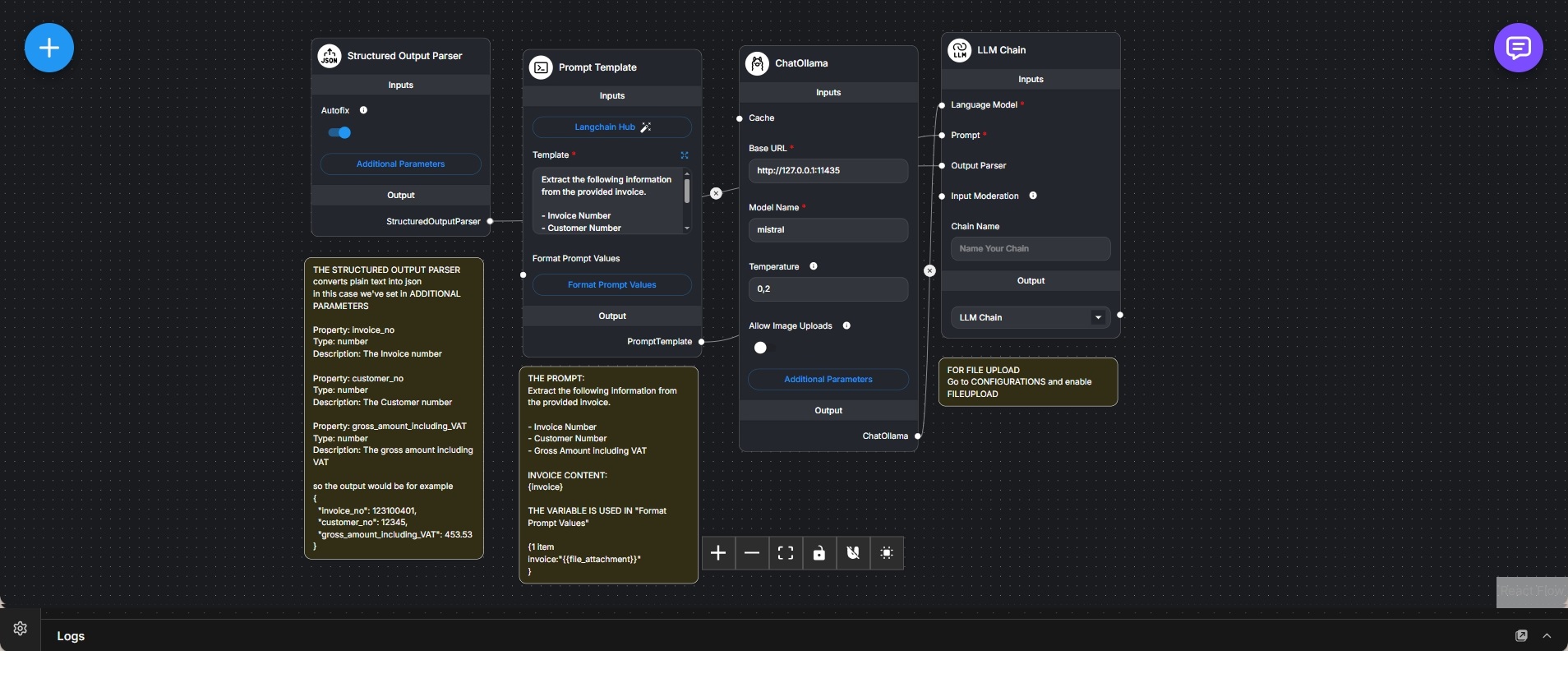

Ein hochgeladenes Rechnungsdokument wird in eine Prompt-Vorlage eingebettet, die das Sprachmodell explizit anweist, vordefinierte Felder wie Rechnungsnummer, Kundennummer und Bruttobetrag inklusive Mehrwertsteuer zu extrahieren. Der Prompt ist bewusst eng gehalten, um Mehrdeutigkeiten und Halluzinationen zu vermeiden.

Ein Structured-Output-Parser definiert ein festes Schema für das erwartete Ergebnis. Jedes Feld ist typisiert und beschrieben, sodass die Textausgabe des Modells in ein striktes JSON-Format überführt werden kann. Eine automatische Korrekturfunktion erhöht die Robustheit bei kleineren Formatabweichungen.

Das lokal betriebene Ollama-Sprachmodell wird über eine LLM-Chain aufgerufen, die Prompt-Vorlage, Modellkonfiguration und Output-Parser in einem Schritt kombiniert. Die Temperatur ist niedrig eingestellt, um Genauigkeit und Konsistenz gegenüber kreativer Variation zu priorisieren.

Das Ergebnis ist eine saubere, maschinenlesbare Datenstruktur, die direkt in Buchhaltungssysteme, Prüfprozesse oder weitere Automatisierungen integriert werden kann. Dokumenteneingang, Extraktionslogik, Modellausführung und Ausgabeverarbeitung sind klar voneinander getrennt.

Der Workflow eignet sich besonders für Rechnungsverarbeitung und Dokumentendigitalisierung, bei denen lokale Ausführung, Datenschutz und strukturierte Ergebnisse entscheidend sind.