Lokale Chat-Oberfläche mit Ollama und Gesprächsspeicher

Lokaler Chat-Workflow, der ein über Ollama betriebenes Sprachmodell mit einer fensterbasierten Speicherkomponente kombiniert.

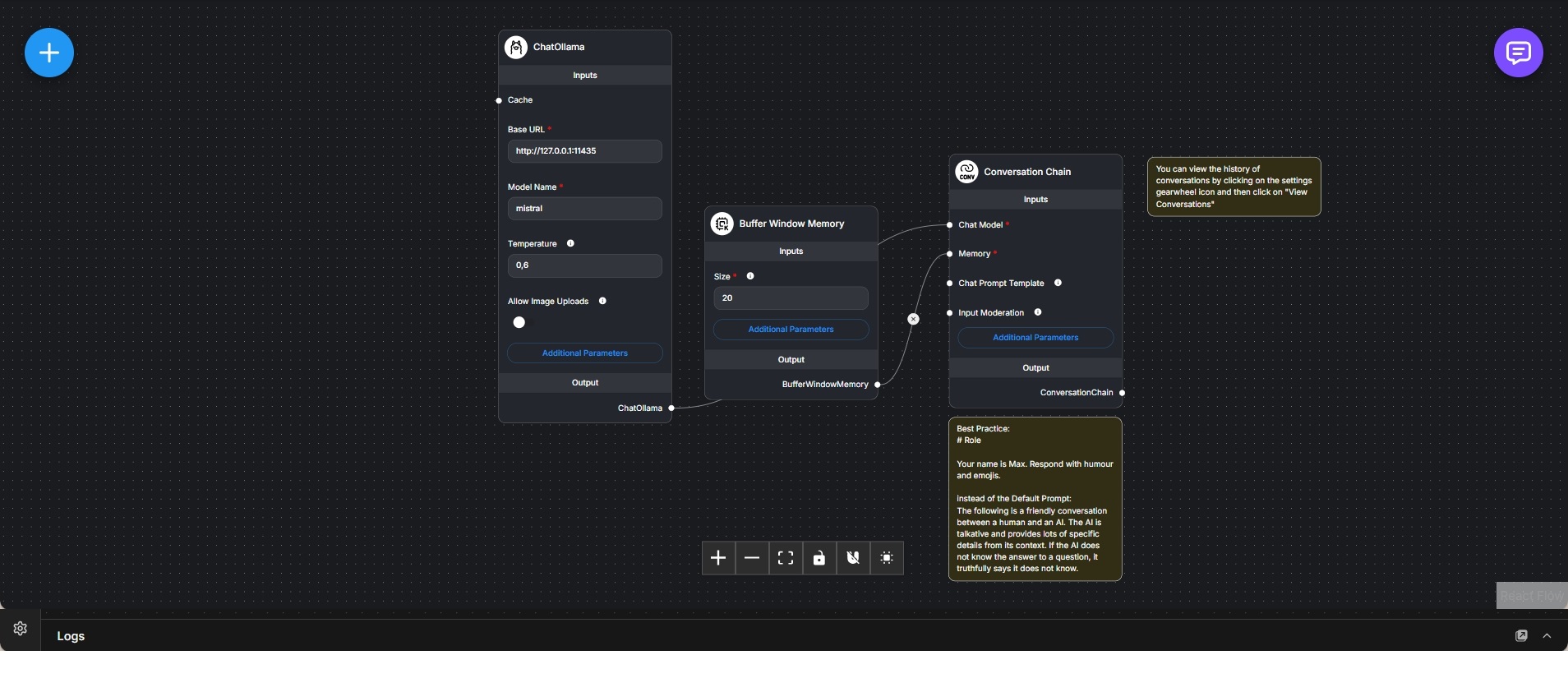

Dieser Workflow implementiert ein lokales, ChatGPT-ähnliches Konversationssetup auf Basis eines über Ollama betriebenen Sprachmodells. Ein Chat-Model-Knoten verbindet sich mit einer lokal laufenden Ollama-Instanz und übernimmt die eigentliche Textgenerierung.

Zur Unterstützung mehrstufiger Gespräche kommt eine Buffer-Window-Memory-Komponente zum Einsatz, die eine feste Anzahl der zuletzt ausgetauschten Nachrichten speichert. Dadurch bleibt kurzfristiger Gesprächskontext erhalten, ohne langfristige Historien oder externe Zustände zu persistieren.

Chat-Modell und Speicher werden über eine Conversation-Chain miteinander verbunden. Diese übernimmt den Aufbau der Prompts, die Verwaltung des Gesprächsverlaufs und die Generierung der Antworten. Jede neue Eingabe wird somit im Kontext der vorherigen Nachrichten verarbeitet.

Das Antwortverhalten kann über eine Prompt-Vorlage gezielt angepasst werden, etwa um Rollen, Tonfall oder Verhaltensregeln zu definieren, unabhängig vom zugrunde liegenden Modell.

Der Workflow stellt eine schlanke, vollständig lokale Chatlösung dar und eignet sich gut für Experimente, Prompt-Validierung oder als Ausgangspunkt für komplexere Systeme, die später um Retrieval, Tools oder Orchestrierung erweitert werden.