Konversations-Chatbot mit Speicher und Eingabemoderation

Lokaler Chat-Workflow, der ein Ollama-Sprachmodell mit Kurzzeitspeicher, promptgesteuertem Verhalten und expliziter Eingabemoderation kombiniert.

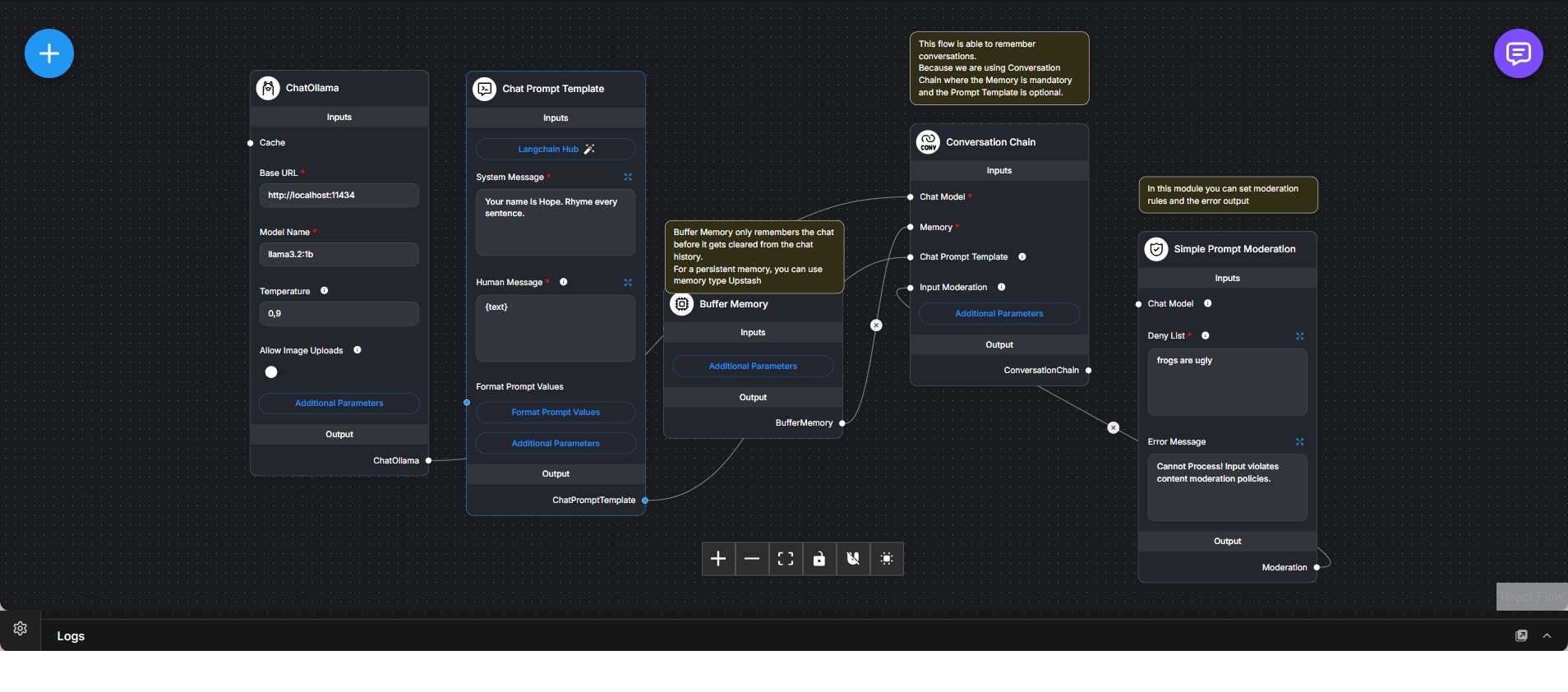

Dieser Workflow implementiert einen kontrollierten Konversations-Chatbot auf Basis eines lokal betriebenen Ollama-Sprachmodells. Das Chat-Modell bildet die zentrale Generierungskomponente und wird über spezifische Parameter hinsichtlich Tonfall und Antwortverhalten konfiguriert.

Eine Chat-Prompt-Vorlage definiert die Systemrolle und Verhaltensregeln des Assistenten, sodass Persönlichkeit und Stil konsistent über alle Interaktionen hinweg angewendet werden. Nutzereingaben werden vor der Verarbeitung in diese Vorlage eingebettet.

Zur Unterstützung mehrstufiger Gespräche kommt eine bufferbasierte Speicherkomponente zum Einsatz. Diese speichert eine begrenzte Anzahl der zuletzt ausgetauschten Nachrichten und ermöglicht so kontextbezogene Antworten ohne langfristige Persistenz. Die Verwaltung erfolgt über eine Conversation Chain.

Zusätzlich ist ein Eingabemoderationsmodul in den Workflow integriert. Dieses prüft eingehende Nachrichten anhand einer definierten Deny-Liste und blockiert Anfragen, die gegen die festgelegten Regeln verstoßen. In solchen Fällen wird eine kontrollierte Fehlermeldung ausgegeben, anstatt die Anfrage an das Sprachmodell weiterzuleiten.

Die Conversation Chain fungiert als zentrale Koordinationsschicht, in der Modellaufruf, Speicherverwaltung, Prompt-Logik und Moderation zusammengeführt werden. Dadurch entsteht ein ausgewogenes System aus konversationaler Flexibilität und klarer Kontrolle über Verhalten und Sicherheit.

Der Workflow eignet sich für lokale Chatbot-Szenarien, bei denen Gesprächskontext, definierte Persönlichkeit und grundlegende Moderation erforderlich sind, ohne auf externe Cloud-Dienste angewiesen zu sein.