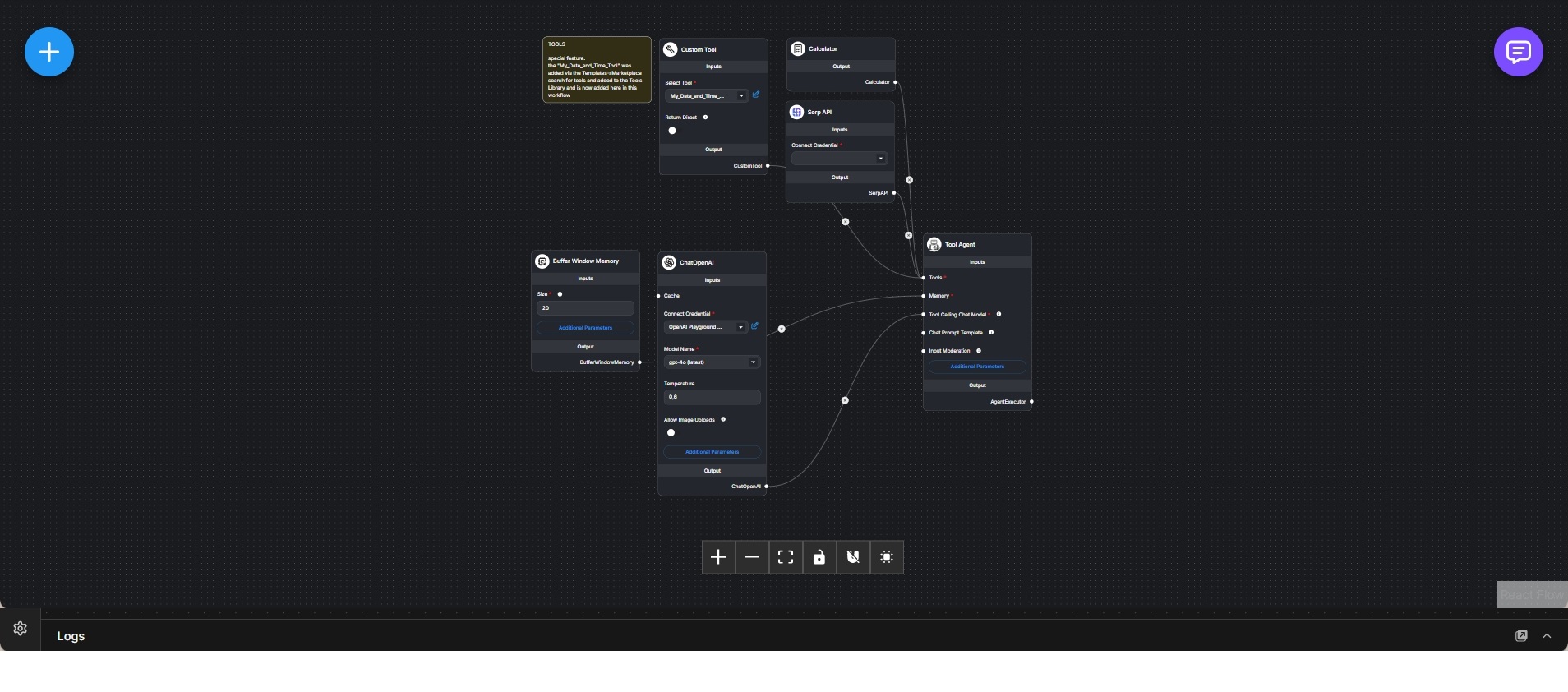

Cloud-basierter Research-Tool-Agent mit OpenAI, Memory und externen Utilities

Tool-gestützter Research-Agent, der OpenAI-Sprachmodelle mit Rechner-, Such- und Custom-Tools für fundierte Analyse kombiniert.

Dieser Workflow implementiert einen cloudbasierten Research-Agenten, der Sprachmodell-Reasoning mit deterministischen Tools und externen Datenquellen erweitert. Die Architektur entspricht der lokalen Ollama-Variante, nutzt jedoch ein OpenAI-gehostetes Chatmodell als Reasoning-Engine.

Der ChatOpenAI-Knoten stellt ein leistungsfähiges Cloud-Modell bereit, das für zuverlässige Tool-Aufrufe und komplexe Analyseaufgaben optimiert ist. Die Modellparameter sind so gewählt, dass Genauigkeit und flexible Interpretation von Nutzeranfragen im Gleichgewicht bleiben.

Ein Buffer-Window-Memory speichert kurzfristigen Gesprächskontext und ermöglicht mehrstufige Rechercheprozesse, bei denen Zwischenergebnisse und Tool-Ausgaben in weitere Denkprozesse einfließen.

Der Agent ist als Tool-Agent konfiguriert und erhält Zugriff auf eine klar definierte Tool-Sammlung. Dazu gehören ein Rechner für präzise Berechnungen, eine SERP-API für aktuelle Websuchen sowie ein benutzerdefiniertes Tool für zusätzliche Logik wie Datums- und Zeitfunktionen. Tool-Aufrufe erfolgen ausschließlich bei Bedarf.

Während der Ausführung entscheidet der Agent selbstständig, wann externe Tools genutzt werden müssen, integriert deren Ergebnisse in den Kontext und erzeugt Antworten auf Basis verifizierter Informationen statt bloßer Annahmen.

Der Workflow zeigt, wie cloudbasierte Sprachmodelle als Orchestrierungsschicht eingesetzt werden können, während Faktenbeschaffung und Berechnungen an spezialisierte Tools delegiert werden. Er eignet sich besonders für Rechercheassistenten, analytische Workflows und produktive Umgebungen mit hohen Anforderungen an Genauigkeit, Skalierbarkeit und Aktualität.