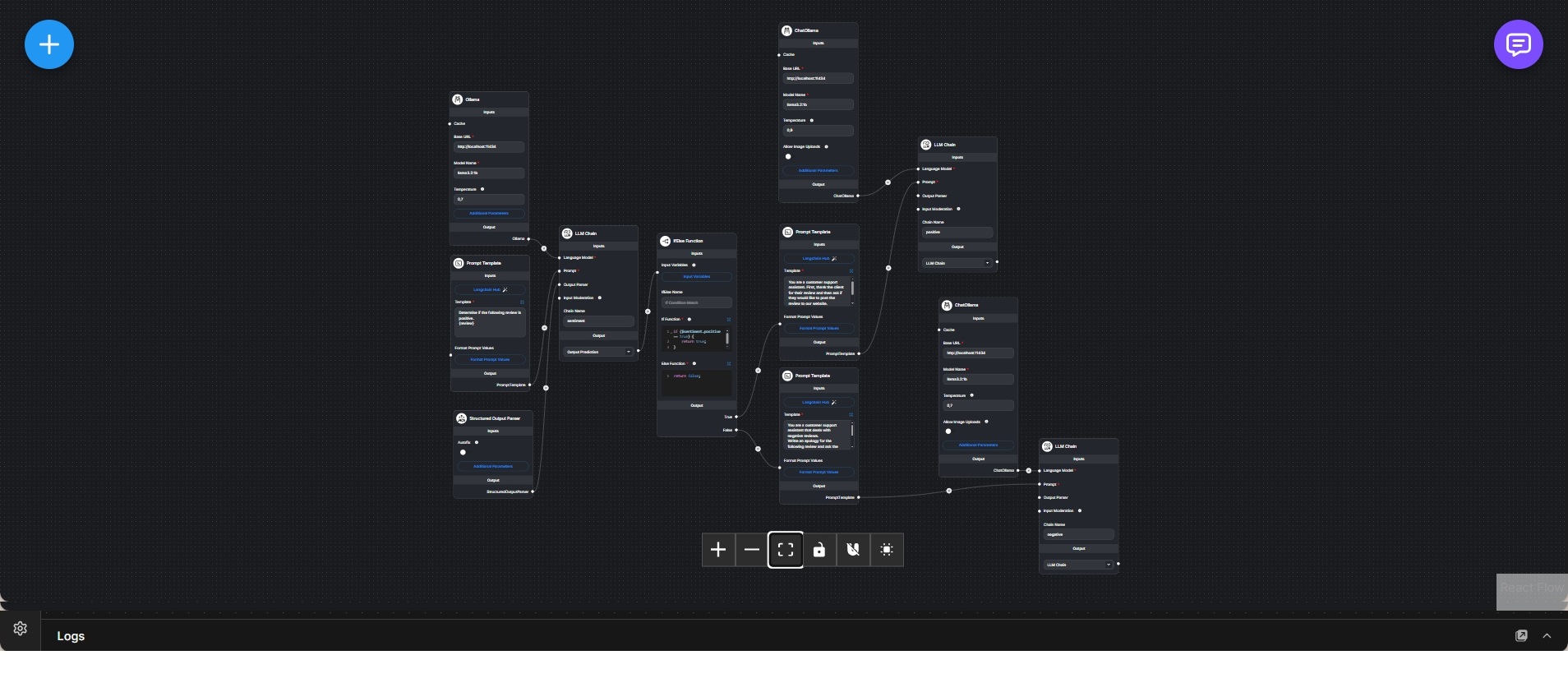

Bedingter Antwort-Workflow mit Ollama und strukturierter Ausgabe

Mehrstufiger Flowise-Workflow, der Nutzereingaben auswertet und abhängig von Bedingungen unterschiedliche strukturierte Antworten erzeugt.

Dieser Workflow implementiert eine bedingte Chat-Pipeline, deren Verhalten sich dynamisch am Inhalt der Nutzereingabe orientiert. Er demonstriert kontrolliertes Routing, strukturierte Ausgabe und spezialisierte Prompt-Logik innerhalb eines einzelnen Flowise-Graphs.

Im Zentrum des Workflows steht ein lokal betriebenes Ollama-Sprachmodell zur Textgenerierung. Die Nutzereingabe wird zunächst über eine Prompt-Vorlage und eine LLM-Chain verarbeitet, die eine strukturierte Zwischenantwort erzeugt. Anschließend normalisiert ein Structured-Output-Parser das Modellresultat in ein vorhersehbares Format, das programmatisch ausgewertet werden kann.

Ein bedingter Funktionsknoten analysiert diese strukturierte Ausgabe und entscheidet, welchem Ausführungspfad der Workflow folgen soll. Abhängig von dieser Entscheidung wird die Anfrage an unterschiedliche Prompt-Vorlagen und LLM-Chains weitergeleitet, die jeweils auf einen bestimmten Antworttyp oder Anwendungsfall zugeschnitten sind.

Jeder Zweig nutzt eigene Prompt-Konfigurationen und Modellaufrufe, bleibt jedoch auf derselben Modellinfrastruktur aufgebaut. Dadurch lassen sich unterschiedliche Verhaltensweisen wie Klassifikation, Erklärung oder aufgabenspezifische Antworten sauber voneinander trennen.

Der Workflow legt den Fokus auf explizite Kontrolle über das Modellverhalten und eignet sich besonders für Anwendungsfälle, bei denen deterministisches Routing und vorhersehbare Ausgaben wichtiger sind als freie Konversation.