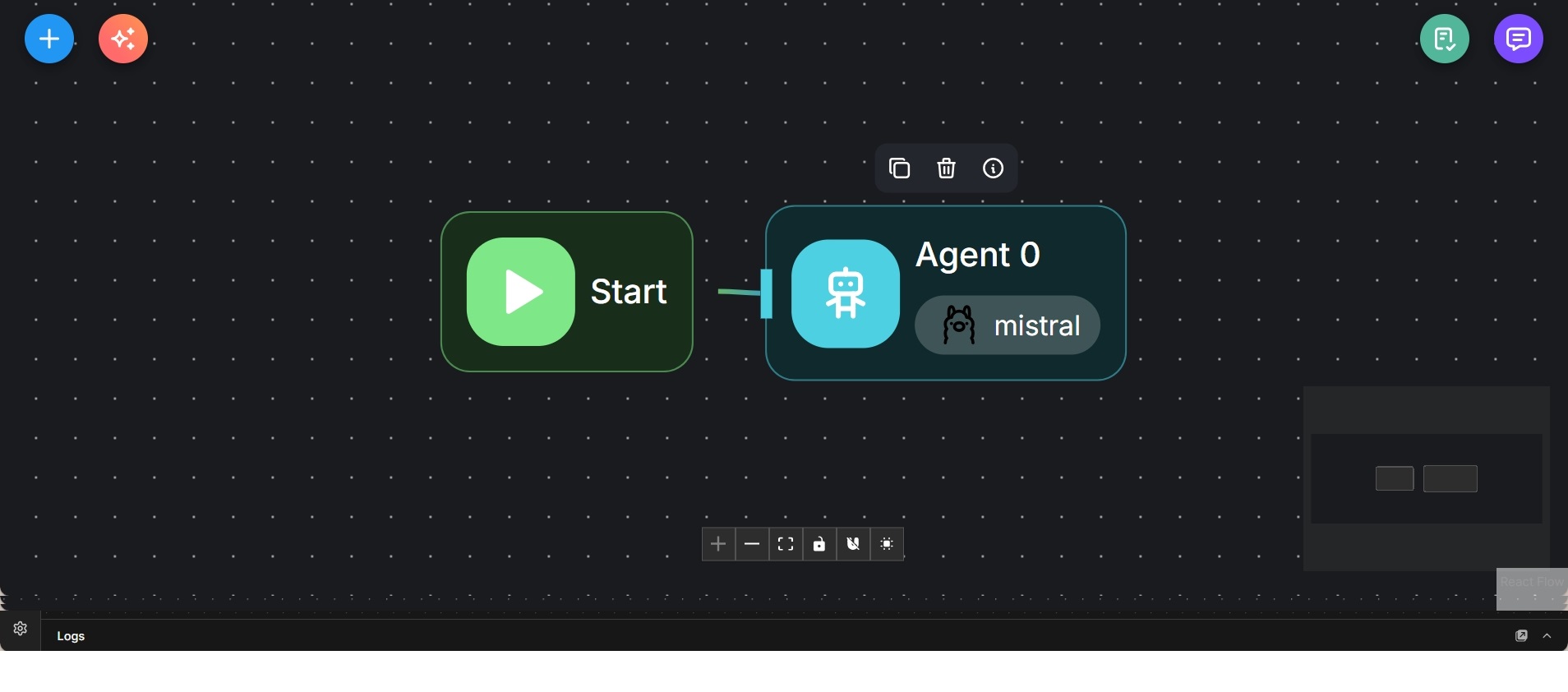

Minimaler lokaler Chat-Agent mit Mistral-Modell

Einfacher Flowise-Workflow mit einem einzelnen Agenten zur direkten Chat-Interaktion mit einem lokalen Sprachmodell.

Dieser Workflow stellt ein minimales Flowise-Setup dar, das ausschließlich aus einem einzelnen KI-Agenten besteht. Die Ausführung beginnt direkt und leitet die Eingabe ohne zusätzliche Planungs-, Routing- oder Iterationslogik an den Agenten weiter.

Der Agent nutzt ein lokal betriebenes Mistral-Modell für Sprachverständnis und Antwortgenerierung. Es kommen keine externen Tools, Retrieval-Schritte oder Sub-Agenten zum Einsatz, wodurch die Interaktion vollständig modellgetrieben bleibt.

Der Workflow dient als saubere Basis für lokale LLM-Interaktion. Er eignet sich zum Testen von Modellverhalten, zur Validierung von Prompts oder als Ausgangspunkt für komplexere Agenten-Graphen, die später um Speicher, Retrieval oder Orchestrierung erweitert werden können.

Der Aufbau legt bewusst den Fokus auf Einfachheit und Nachvollziehbarkeit, sodass das Verhalten des Modells isoliert betrachtet werden kann.